La creación de la Inteligencia Artificial ha sido uno de los escollos fundamentales de la transformación digital en el último siglo. Desde sus inicios en la década de 1950, cuando las máquinas sólo se enfrentaban a alguien en una partida de ajedrez, la revolución de la IA se ha expandido enormemente para permitir que las máquinas se adapten, aprendan y procesen a un nivel que iguala (y a veces supera) el pensamiento humano. Hoy en día, los sistemas informáticos de IA pueden replicar fácilmente el comportamiento y los patrones de pensamiento humanos usando algoritmos de machine learning para formar reglas. Sin embargo, con un gran poder viene una gran responsabilidad y grandes consecuencias.

Este artículo de blog se centra en el hackeo con IA y en cómo los ciberataques con IA fueron aumentando enormemente desde que empezó el uso generalizado de esta tecnología. Analizamos cómo la IA puede ser usada para cometer ciberdelitos, las amenazas emergentes de IA y cómo la IA puede ayudar a los hackers a captar víctimas. También veremos estafas específicas con IA que se hacen y cómo usar la IA inteligentemente para prevenir ciberataques. Primero, revisemos brevemente cómo se han hecho populares los ciberataques con IA.

El Auge de los Ciberataques Basados con IA

La pandemia de ciberataques con IA está lejos de ser un descubrimiento, el potencial para esas consecuencias desastrosas estaba previsto desde el principio por varios expertos en ciberseguridad. La IA permite a los actores de amenazas automatizar y simplificar los procesos de hackeo, generando una vía fácil para los novatos y los recién llegados. El auge de la IA en la mayoría de los productos de uso corriente, la ha convertido sin duda en una de las tecnologías más codiciadas para las empresas. Esto llevó a los desarrolladores de IA a producir más modelos en menor tiempo. Sin embargo, con intereses comerciales particulares, esos desarrolladores podrían ignorar los riesgos potenciales.

Un informe reciente del Centro Nacional de Ciberseguridad del Reino Unido (NCSC) confirma que la IA “casi con total seguridad, aumentará el volumen y agudizará el impacto de los ciberataques en los próximos dos años.” El mismo informe también afirma que la IA ha abierto el campo del hacking a ciberdelincuentes oportunistas que podrían no tener las habilidades necesarias para orquestar un ciberataque ellos mismos. Esto significa que la IA está volviendo al hacking más accesible y más fácil de usar, animando a los hackers a recurrir a la IA para llevar a cabo o suplementar sus ataques.

En otra entrevista en vídeo con el Information Security Media Group en la RSA Conference 2024, JC Raby, director general y responsable de tecnologías emergentes en JP Morgan Investment Banking, habló sobre las amenazas en el mercado emergente. Señaló que la IA sólo terminará acelerando esas amenazas, dado que se puede montar un ataque a gran escala usando varias herramientas de visibilización y gestión de la superficie de ataque. Ya que la IA ha llegado para quedarse, las organizaciones deben estar conscientes de cómo será utilizada en su contra para cometer ciberataques y robar sus datos.

¿Cómo se Usa la IA para la Ciberdelincuencia?

La IA es una tecnología compleja que crece y puede alimentarse cada día. Esto significa que los sistemas informáticos pueden ser entrenados para completar tareas según se necesite. Sin embargo, sin ninguna persuasión moral, también se puede enseñarle a ejecutar ciberataques. Una de las maneras de utilizar la IA es mediante el uso de tecnologías de IA Generativa Estos son modelos de IA que pueden generar nuevos contenidos, como texto, imágenes, videos, etc. La IA Generativa ya ha desatado polémica en muchos campos y se ha convertido en un escape para que muchas empresas exploten y generen contenidos sin emplear artistas o creadores.

Los Modelos de Lenguaje Grande (LLMs) son un ejemplo de IA Generativa ampliamente utilizada hoy. Las plataformas como ChatGPT fácilmente pueden generar contenidos y responder preguntas, con imprecisiones la mayoría de las veces. La mayoría de las grandes empresas, como Google, Meta, Apple iPhone y otras, también han empezado a utilizar la IA generativa en sus productos. En términos de ciberamenazas, como mínimo, los actores de amenazas pueden usar IA Generativa para crear automáticamente emails o documentos convincentes para captar a la gente en campañas de phishing.

La IA Generativa también se puede utilizar para crear malware capaz de evolucionar para auto-ajustarse según sea necesario para infiltrarse en una red o explotar una vulnerabilidad. Además, la IA puede usarse para crear videos falsos y manipular a la gente. La IA es una herramienta innovadora que puede aprovecharse para crear ciberamenazas con capacidad de auto-aprendizaje, que sean cada vez más persuasivas y preocupantemente invulnerables. Ahora, profundicemos en identificar qué es un ciberataque con IA y cómo puede ser utilizado.

¿Qué Son los Ciberataques con IA?

Los ciberataques con IA pueden definirse como cualquier operación de hacking que dependa del uso de mecanismos de IA. Un hackeo con IA usará los algoritmos avanzados de machine learning de las plataformas de IA para identificar vulnerabilidades, predecir patrones y explotar puntos débiles en las redes. La naturaleza adaptable y automatizada de la IA también ayuda a que los actores de las amenazas analicen datos y se infiltren en sistemas más rápido de lo que pueden proteger las medidas de ciberseguridad tradicionales. Dándoles una ventaja táctica a los hackers en sus ataques.

Un ciberataque de IA tiene la capacidad única de aprender dónde falló y corregirse inmediatamente, ayudándolo a evitar la mayoría de los protocolos de ciberseguridad que existen hoy en día. Además del análisis en tiempo real y la adaptabilidad, el hacking con IA también dificulta mucho el proceso de investigación al eliminar los registros. Estos son típicamente utilizados para hallar las “huellas dactilares” y encontrar a los actores del ataque. Esto convierte a los ciberataques con IA en una formidable amenaza para la ciberseguridad. Ahora explicaremos algunas de las amenazas y estafas emergentes con IA que existen hoy en día.

Amenazas y Estafas Emergentes con IA

A medida que la Inteligencia Artificial va ganando interés, los hackers están empezando a servirse de esta tecnología en nuevas e innovadoras maneras. La IA Generativa ha sido una de las piedras angulares de estos avances, con los hackers utilizando sistemas de aprendizaje automático para orquestar ataques de ingeniería social y estafas de phishing, generando emails creíbles, documentos y otros elementos que inyecten malware o roben credenciales. La IA también puede ser empleada para imitar el comportamiento humano y puede ser extremadamente difícil de identificar para las personas desprevenidas y confiadas.

El Comité Especial de Envejecimiento del Senado de EE.UU publicó un informe para ayudar a los civiles mayores a detectar estafas con IA que podrían ser lanzadas por hackers. El informe advierte que los chatbots simulan conversaciones humanas y podrían ser utilizados por hackers para recabar información personal. Los actores de amenazas también pueden usar deepfakes o técnicas de clonación de voz para imitar a personas de confianza y obtener información o detalles privados. Otro ejemplo está en las estafas de inversión en criptomonedas que usan deepfakes de celebridades para promocionar sus proyectos y buscar inversiones. El anterior director de operaciones de Binance, Patrick Hillmann, fue el objetivo de estafadores con deepfakes con IA en 2022, cuando usaron su imagen en un intento de estafar a víctimas potenciales del sector de las cripto.

Aunque la mayoría de los Modelos de Lenguaje Grande han sido capaces de identificar y evitar que sus plataformas se utilicen para generar malware, los hackers siguen encontrando maneras de engañar al sistema. Esto ha dado lugar a la aparición de plataformas de hacking como Hacked GPT y WormGPT que asisten abiertamente a los actores de amenazas a generar malware. Estas herramientas de hacking sin ética pueden utilizarse para hackear, robar tarjetas, identidades, exfiltrar datos y mucho más. Para protegerse eficazmente del hacking con IA, es importante entender cómo se usa la IA para atacar a las personas.

¿Cómo Usan los Hackers y los Estafadores la IA para Atacar a la Gente?

La IA puede utilizarse de diversas maneras para aumentar o elevar un ciberataque o una estafa de ingeniería social. Un informe de 2020 del Georgetown Center for Security and Emerging Technology analizó el uso potencial de la IA en algunas de las mismas actividades e identificó áreas de riesgo similares. Indicaba que la automatización era un factor importante para algunos hackers que se vuelcan a las técnicas de machine learning para lanzar ciberataques. El reporte también menciona que el aprendizaje automático tiene el potencial de aumentar tanto la escala como la tasa de éxito de los ataques de phishing selectivo y de ingeniería social.

Esto significa que la IA se utiliza a menudo para generar falsos emails, archivos adjuntos y mensajes para atraer a personas incautas o ingenuas en una empresa o individuos desprevenidos a facilitar sus credenciales o inyectar malware en su red sin saberlo. La IA también se puede utilizar para detectar vulnerabilidades en un sistema en cuestión de segundos y poder explotarlas. Esto se puede hacer revirtiendo comparaciones entre versiones publicadas de software para identificar lo que se ha parcheado o analizando el código de fuente abierto. La velocidad de la IA es una parte crucial de este proceso. Ahora, podemos explorar las amenazas más específicas con IA en más detalle para ver cómo los actores de amenazas atacan a las personas.

Amenazas de Hacking con IA

Las amenazas de hacking con IA se presentan de diversas maneras y formas. Con la tecnología de IA en constante aprendizaje y evolución para resolver problemas más complejos (o infiltrarse en sistemas de seguridad más complejos), es de esperar que el número de amenazas de hacking con IA a las que tendríamos que hacer frente no hagan más que crecer. Por ahora, podemos enumerar algunas de las principales amenazas de ciberataque con IA a las que hay que prestar atención:

1. Hackeo con Deepfake con IA

Los deepfakes se crean utilizando IA generativa para imitar la semejanza de un ser humano. Normalmente los deepfakes se utilizan con fines promocionales y se aprovechan de la imagen de celebridades, políticos u otras figuras de autoridad para promocionar una marca o un proyecto. Un deepfake utilizará grabaciones de vídeo, fotografías y grabaciones de voz existentes para generar clips de vídeo y sonidos generados con IA. La IA puede utilizar el intercambio de caras y la manipulación facial para imitar los movimientos faciales de la víctima y crear vídeos aparentemente legítimos para estafar a la gente.

Aunque pueda parecer una estafa bastante simple el engañar a tus abuelos haciéndoles creer que Tom Cruise quiere que se compren un iPhone, los deepfakes pueden afectar a cualquiera. Los ataques con deepfakes persuaden a los empleados para que entreguen información confidencial a figuras supuestamente de confianza. Estos vídeos también pueden utilizarse para difundir propaganda y pueden tener graves implicaciones en tiempos de agitación política o incertidumbre, causando daños a la reputación, desinformación y pérdidas financieras. El Foro Económico Mundial informó que el 66% de los profesionales de la ciberseguridad han experimentado ataques de deepfakes en sus respectivas organizaciones solo en el año 2022.

2. Generación de Malware para Hacking con IA

La IA Generativa puede utilizarse para crear malware polimórfico que se adapta y muta su código fuente para evitar la detección y evadir los protocolos de seguridad. Para los sistemas antivirus tradicionales que usan la identificación basada en firmas, esto puede resultar difícil de defender. Aunque la generación de malware con IA está intentando ser frenada por la mayoría de las plataformas, hay varios foros de la deep web que siguen ofreciendo creación de malware con IA.

3. Ingeniería Social con IA

Los ataques de ingeniería social se centran en manipular a las personas para que faciliten sus credenciales o abran enlaces sospechosos o archivos adjuntos. Con el uso de la IA, los hackers pueden elaborar estafas de ingeniería social automatizadas y eficientes para engañar a la gente y obtener acceso a datos privados.

4. Ataques de Fuerza Bruta con IA

Un ataque de fuerza bruta intentará agotar todas las combinaciones de contraseñas para vulnerar una ubicación segura. Con la incorporación de la IA, los ataques de fuerza bruta pueden automatizarse a la perfección y permitir a los hackers analizar el comportamiento y los patrones de los usuarios para averiguar las contraseñas mucho más rápido.

5. Hackeo Phishing con IA

Otra amenaza común del hacking con IA es el aumento del phishing. Estos ataques se basan en engañar a los empleados o individuos haciéndoles creer que la correspondencia procede de una fuente legítima. La IA ha agilizado las capacidades de estos ataques al generar emails de phishing automatizados y eficientes que son más personalizados, aumentando su legitimidad.

Esto es porque la IA puede observar y adaptar los patrones de la estafa de phishing según un análisis en profundidad. Harvard Business Review reportó que el 60% de los participantes fueron víctimas del phishing automatizado con IA en comparación con las estafas de phishing sin IA. La automatización del phishing con LLM también reduce los costos de los ataques en más de un 95%, al tiempo que consigue tasas de éxito iguales o superiores, convirtiéndola en la opción más atractiva para los actores de amenazas.

6. Cracking de CAPTCHA con IA

Los CAPTCHA se han usado por mucho tiempo para acabar con los bots en internet y determinar si un usuario es humano. Sin embargo, ahora la IA ha demostrado ser mejor a la hora de resolver formularios CAPTCHA analizando imágenes y eligiendo según los patrones de comportamiento humano aprendidos.

7. Hackeo con Clonación de Voz con IA

Así como las falsificaciones visuales pueden ser problemáticas, la clonación de la voz puede ser igualmente peligrosa en las manos equivocadas. La biometría vocal es una medida de seguridad bastante común en muchos dispositivos y sistemas. Hoy, la IA puede duplicar huellas de audio e imitar clips de voz a partir de nuestras vocales. Esto significa que los sistemas protegidos por voz son vulnerables y que se puede engañar a la gente haciéndole creer que un archivo de audio es legítimo cuando no lo es, lo que permite el hacking, la desinformación y el robo de identidad.

8. Espionaje de Tecleo con IA

Otra forma en que la IA puede convertirse en una amenaza es espiando el tecleo del teclado. Algunas herramientas de IA pueden grabar activamente las diferentes teclas que escribes en el teclado para robar contraseñas con una precisión de casi el 95%.

Todas estas amenazas con IA pueden utilizarse de diferentes maneras para robar datos y credenciales. Aunque estos métodos pueden parecer inverosímiles, el hacking con IA se basa en esta despreocupación para prosperar. Para comprender realmente los efectos y ramificaciones de los ciberataques con IA y el estado de la ciberseguridad, exploremos algunas estadísticas aleccionadoras.

Estadísticas sobre Hacking y Ciberseguridad con IA

Cuando se trata de la IA en ciberseguridad , muchas empresas y desarrolladores se apresurarán en cubrir sus balances antes de configurar una protección efectiva para herramientas con IA. La amenaza que supone la IA para la ciberseguridad no puede ignorarse por más tiempo y las organizaciones tienen la responsabilidad de educarse a sí mismas y sus empleados sobre los riesgos de ciberataques con IA. Si bien los hackeos con IA pueden ser difíciles de detectar y remediar, es imperativo saber cómo los hackeos con IA han transformado el panorama de la ciberseguridad en un campo de juego inestable. Aquí hay algunas estadísticas que deben utilizarse para informar su postura sobre los ciberataques con IA::

- Se estima que el mercado mundial de productos de ciberseguridad basados en IA alcanzará los $133.800 millones de dólares en 2030, frente a los $14.900 millones del año pasado. (CNBC)

- Hasta el 90% de los contenidos en línea podrían ser generados sintéticamente para el año 2026. (WeForum)

- Las empresas afectadas por estafas con IA no solo sufren pérdidas económicas directas, sino que también se enfrentan a la erosión de la confianza de sus clientes y a posibles ramificaciones legales. (2024 Sophos Threat Report)

- El uso de IA en el Reino Unido casi con certeza hará que los ciberataques sean más impactantes, porque los actores de amenazas podrán analizar los datos filtrados con mayor rapidez y eficacia y utilizarlos para entrenar modelos de IA.

- El 75% de los profesionales de la seguridad han sido testigos de un aumento de los ataques en los últimos 12 meses, y el 85% atribuyen este aumento a los actores maliciosos que usan IA generativa. (SecurityMagazine)

- Alrededor del 48% de los responsables de IT no confían en disponer de la tecnología necesaria para defenderse de los ataques con IA. (Forbes)

- Sólo el 52% de los responsables en la toma de decisiones de IT expresaron una alta confianza en su capacidad para detectar un deepfake de su CEO. (Forbes)

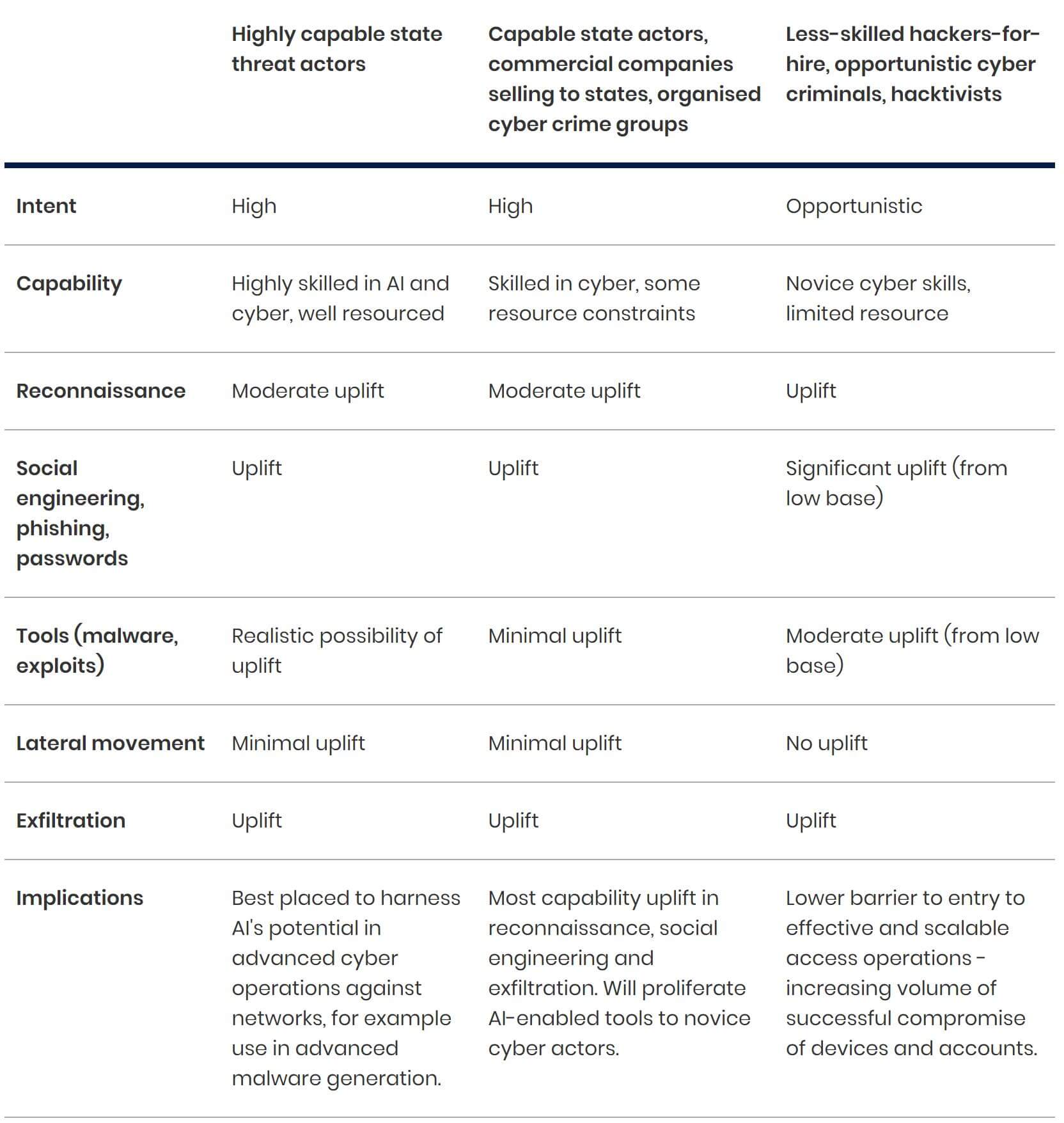

- La IA reduce la barrera de entrada para los ciberdelincuentes novatos, los hackers pagos y los hacktivistas para llevar a cabo operaciones eficaces de acceso y recopilación de información. Este acceso mejorado contribuirá probablemente a la amenaza mundial del ransomware en los próximos dos años. (NCSC)

- A partir de 2025, la comercialización de la capacidad de la IA en los mercados criminales y comerciales, casi con seguridad pondrá a disposición de la ciberdelincuencia y los agentes estatales una capacidad mejorada. (NCSC)

El informe de NCSC del Reino Unido también afirma que es casi seguro que la IA aumentará el volumen y agudizará el impacto de los ciberataques en los próximos dos años. Sin embargo, el impacto de la ciberamenaza será desigual.

Cuadro 1: Alcance del aumento de la capacidad causado por la IA en los próximos dos años. Fuente NCSC.

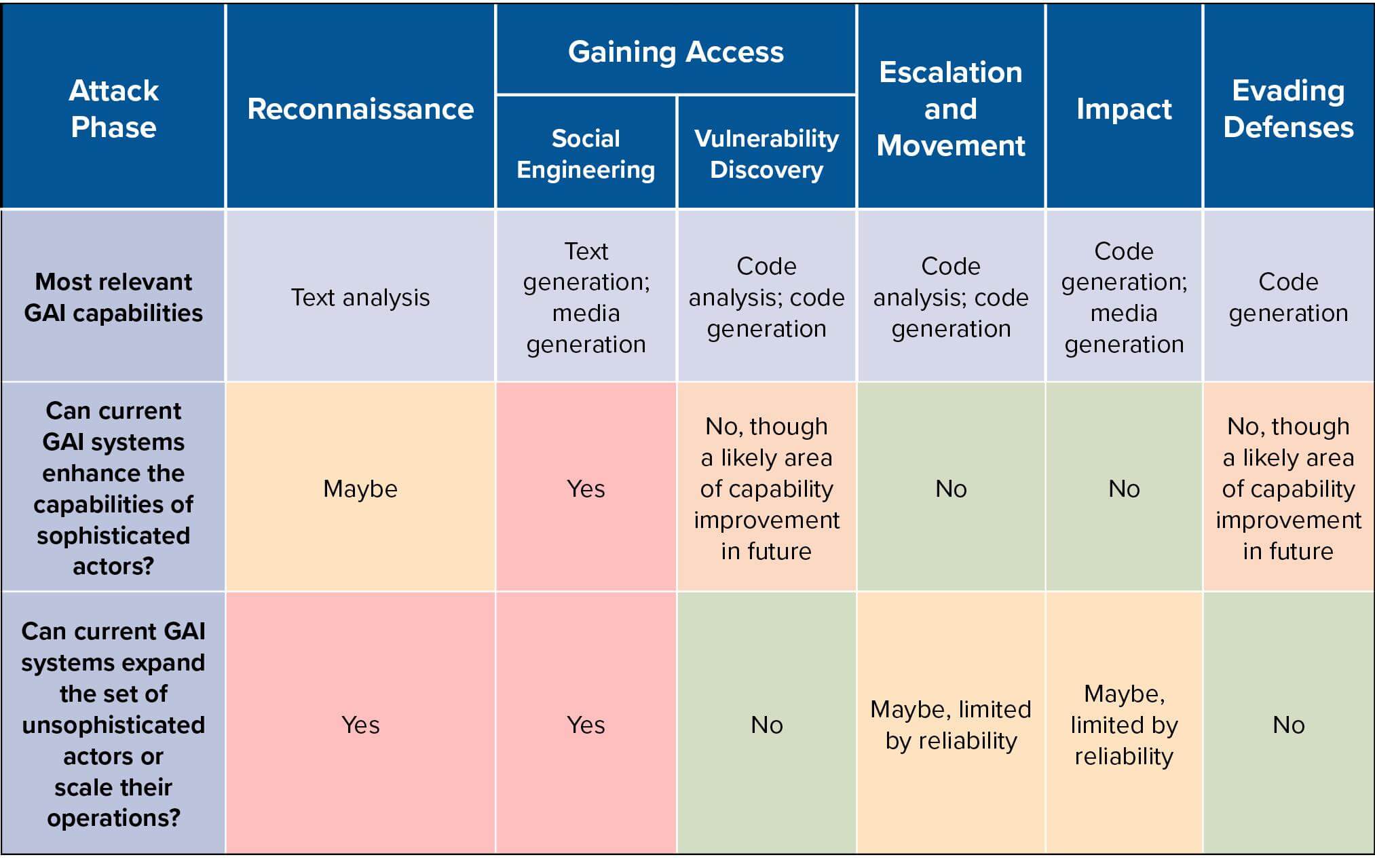

Otro informe de Maia Hamin y Stewart Scott relaciona las capacidades actuales de los modelos de IA Generativa (GAI) con las fases del ciclo de vida de un ciberataque. Esto ayuda a analizar si estos sistemas podrían alterar el panorama cibernético y de qué manera.

Cuadro 2: Resumen de las capacidades GIA relevantes y nivel de mejora de las capacidades en las diferentes fases de vida del ciberataque. Fuente Hacking with AI report

Aunque aún no hay evidencias de que los sistemas LLM puedan completar múltiples fases de un ciberataque completo sin intervención humana, varios factores exigen que se siga prestando atención a esta cuestión. Esto implica estudiar la forma en que el paradigma del aprendizaje no supervisado crea un exceso de capacidades, así como aumentar la atención y la energía de desarrollo en torno a los sistemas autónomos. Para enfrentar estos desafíos, el informe también concluye con recomendaciones de políticas para sistemas con IA. Que incluyen:

- Desarrollar normas de testeo para modelos de vanguardia que evalúen los ciber-riesgos en diferentes fases, actores y niveles de autonomía, priorizando la transparencia y la participación.

- Evaluar y gestionar los riesgos cibernéticos derivados de los sistemas GAI, protegiendo al mismo tiempo la equidad del desarrollo de modelos abiertos.

- Movilizar recursos para acelerar el trabajo técnico y normativo sobre el etiquetado de contenidos de IA enfocándose en el potencial de implementación.

- Invertir en estructuras políticas y medidas técnicas para abordar los riesgos potenciales asociados a los agentes autónomos basados en IA.

Limitar el uso indebido de la IA es un inconveniente masivo de la ciberseguridad y que necesita tratarse como tal. Una reciente Orden Ejecutiva sobre la IA de la administración de Biden apunta a los gobiernos a la dirección correcta al exigir que los desarrolladores y los proveedores de Infraestructura como Servicio (IaaS) presenten informes al gobierno federal relacionados con el entrenamiento de “modelos de base de doble uso”, definidos en términos de su capacidad potencial para plantear graves amenazas a la seguridad nacional, como por ejemplo permitiendo operaciones cibernéticas ofensivas automatizadas.

Siguiendo con el mantra de combatir el fuego con el fuego, el mayor avance en la lucha contra el hackeo con IA ha sido, irónicamente, el uso de Soluciones de Ciberseguridad basadas en IA. La Inteligencia Artificial ha demostrado ser crucial en la creación de soluciones de ciberseguridad que puedan predecir, detectar y eliminar las amenazas cibernéticas en tiempo real con gastos reducidos y una precisión impresionante. Las mismas capacidades automatizadas que hacen que el hackeo con IA sea muy fácil pueden utilizarse para analizar grandes conjuntos de datos en busca de anomalías.

Sangfor utiliza IA en varias plataformas de ciberseguridad para agilizar el procesamiento, automatizar tareas y proporcionar soluciones mejoradas de testeo y monitoreo. La plataforma Cyber Command de Sangfor utiliza un algoritmo con IA mejorado para monitorear malware, eventos de seguridad residuales y futuros compromisos potenciales en su red. También está acoplado con la avanzada tecnología de Inteligencia de Amenazas para mantenerlo actualizado ante cualquier vulnerabilidad detectada.

Además, Endpoint Secure de Sangfor utiliza un Motor de Detección con IA y brinda protección integrada contra infecciones de malware e infracciones APT en toda la red de su organización. En las manos adecuadas, la IA puede ser una herramienta estratégica de ciberseguridad, y en última instancia protegerá mejor a su organización en un momento en el que el hacking con IA está en aumento. A pesar de las diversas maneras en que los ciberataques con IA pueden aprovecharse para atacar, es importante invertir en tecnologías que puedan ser realmente efectivas en un clima digital en evolución. Contáctese con Sangfor Technologies hoy mismo para ver cómo podemos utilizar la IA para protegerlo.